※無料でも使えますが取得可能URL等に制限が入ります。

Screaming Frog SEO Spiderって何?

一言でいうと自分のPC内(ローカル環境)で動かす「クローラー」です。「Screaming Frog SEO Spider」で何が確認できるの?

主だった機能だけのご紹介になりますが、クローラーですので指定したURLからリンクを辿って、URLリストを取得していきます。

取得したURLリストから、HTTPステータス500系とか400系のリストなどが取得できます。

タイトル重複やタイトルの文字数が多い/少ないなどのリストが取得できたりします。

簡単なレポーティング機能もあります。

実際にどう活用しているの?

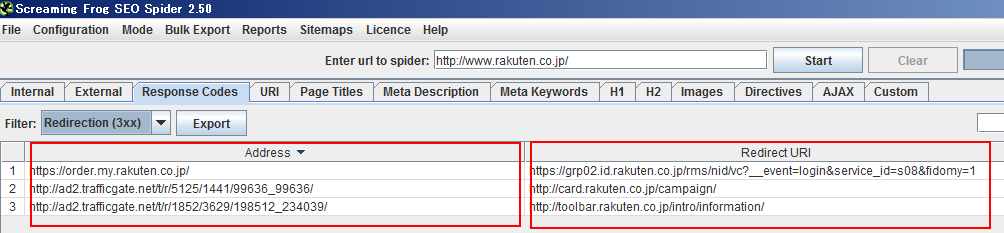

上で軽く触れた事で、大体予想が付くとは思いますが・・・【活用事例1】canonical先/3xxリダイレクト先URLが間違っていないかチェック!

canonicalタグの設定をミスると、Indexから落ちる可能性があります。

canonicalの設定もザックリとツールでチェックしましょう。

3xx系のリダイレクトも一緒です。ちゃんとリストでチェックしましょう。

【活用事例2】タイトル重複・短いタイトル・短いdescriptionチェック

タイトル重複。ウェブマスターツールから引っ張るのも重要ですが、新規ページ群のリリース前のチェックなどでも利用したいところ。

ページのタイトルが短いとクリックされませんよね。重要なページのタイトルが短くなっていないか注意して見ましょう。

ディスクリプションも一緒ですよね。クリックされない一言の説明文が書かれてはいませんか?

【活用事例3】競合分析

今まで紹介してきたものは普通に競合分析としても使えるわけですが、一番よく使うのが「レポート」の「crawl overview」です。どんな項目を比較しても良いのですが、例えばURIを比較してみたり、重複タイトルの比率を比較してみたり。

【活用事例4】リンク切れチェック

4xx系や5xx系のURLリストを出力してみて、リンク切れやおかしいリンクが無いかどうかをチェックしましょう。【活用事例5】パラメータ付きのURLをチェック

たくさんパラメータが付くようなURLが重要なページになってはいませんか?

Indexされたいページなら正規化するなど、ちゃんと対策をしないとダメだと思いますが、ざっくりとでもチェックしてみましょう。

【活用事例6】クロールバジェットを意識したクローリング設定

サーチのDepth設定など、クロールバジェットを意識した設定でクローリングさせ、重要なURLのリストが取得できるかどうかなど、クローラーの設定を変更させながら検証してみましょう。

こんな感じで代わりのツールも色々ありますが、「Screaming Frog SEO Spider」も一つの選択肢として入れてみてはいかがでしょうか?

注意点

・JAVAを利用するアプリなので、メモリを本当に食います。そして食いすぎて停止します。「Screaming Frog SEO Spider」自身が利用するメモリを設定で拡張できます。ただ、それでも10万URL級は相当メモリを積んだマシンでも厳しいものがあります。

Spider自身の設定でリミットを掛けるべきだと思います。

※ちなみに10万URLだと6Gくらいは食います。

・アクセスは常識の範囲内でしましょう。攻撃とみなされるくらいアクセスをしたりしないように!

<ご参考>

Screaming Frog SEO Spiderとその使い方・活用法に関する記事はこちら

0 コメント:

コメントを投稿